〈なぜAI分野がノーベル物理学賞を受賞できたのか? 人工知能(AI)のブレークスルーを生み出した複雑物理系の理論〉から続く

2024年度のノーベル物理学賞、ノーベル化学賞がともにAI関連の受賞であったことは驚きをもって伝えられた。なぜAI関連の受賞が相次いだのか? 人工ニューラルネットワークの概念を確立し、深層学習(ディープラーニング)の発展に大きく貢献したプリンストン大学名誉教授のジョン・ホップフィールドとトロント大学名誉教授のジェフリー・ヒントンのノーベル物理学賞受賞の画期性とは。

その背景には、まず2021年度の「複雑物理系」のノーベル物理学賞受賞があり、今回の受賞はそれと関連して分野を越境してもたらされたものであると日本における複雑系・カオス理論研究の第一人者の津田一郎氏は分析。3回にわたって解説記事をお届けする。(全3回の#2)

◆◆◆

日本人研究者はなぜノーベル賞を逃したか?

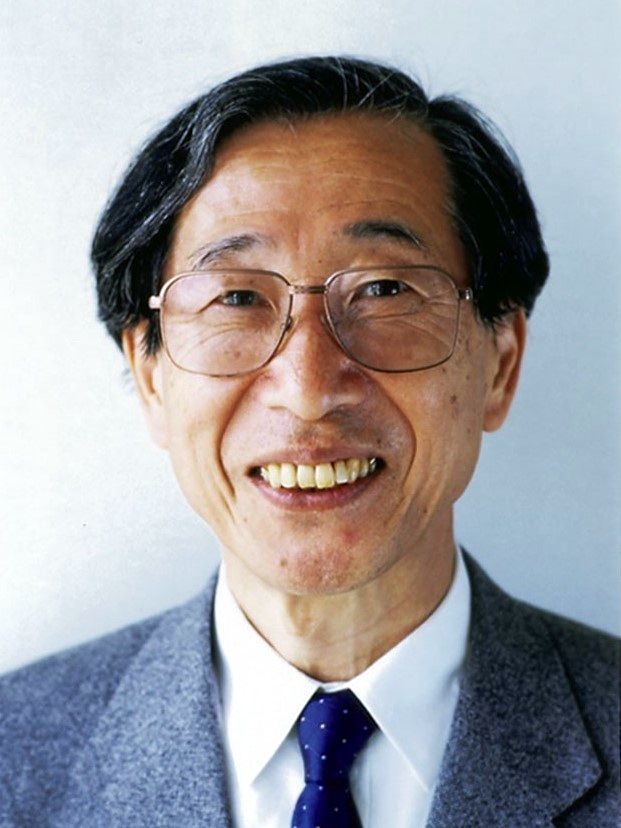

今回委員会が越境したのが人工知能分野である。純粋に人工知能の研究ということなら適任者は他にも大勢いる。また、2000年以降の人工知能は脳の神経回路網を模した人工神経回路(ANN)である。ANNの研究では日本は先駆的であったし、その代表である甘利俊一、中野馨、福島邦彦たちの研究成果は世界的にも早くから認知されてきた。

https://commons.wikimedia.org/wiki/File:Shunichi_Amari_cropped_Shunichi_Amari_201911.jpg

後に詳しく述べるが、我が国におけるANN研究の歴史は古く世界を先導する数々の業績が生まれた。したがって、今回のノーベル物理学賞をANNの先駆的業績を上げてきた日本人にも与えるべきだったという声は、少なくとも日本では多く聞かれる。私の知人もネットで怪気炎を上げた。意気やよしである。しかしながら、この賞は物理学賞なので対象は何らかの形で物理に関係した研究でなければならない。そこを毎回、ノーベル委員会はこだわってきた。

ノーベル委員会のこだわり、「これは物理だ」という防御線

記者会見の場やそのあとに記者や世界中の物理学者から「なぜ、これが物理学賞なのか」、「物理をどう規定しているのか」などと厳しい質問が矢のようにやってくることを承知しているから、彼らは「これは物理だ」と必ず防御線を張る。2021年度の記者会見でも、「なぜ気候変動が物理学賞なのか」という質問があり、委員会担当者は「気象、気候は物理だ。複雑物理系だ」と興奮して強調していた。

対象の研究が物理学の発展にどれだけ寄与したか、あるいは物理学が他分野の発展にどれだけ貢献したか、の二点がポイントである。だから、多くの有力候補が外されている。これは分野名が明記されている以上致し方ないことである。今回名前が上がらなかったが優れた業績を上げている神経回路網の研究者たちは脳を理論的に知りたいと思い長年研究を積み上げてきたのだから、今後別の分野の候補になることはありうるだろう。また、優れた先駆的な業績に賞を与えるというなら、分野ごとの賞ではなく単に「ノーベル賞」とすればよいのだが、これは委員会の専権事項だから筆者のような外野がとやかく言うべきものではない。

委員会とアインシュタインの紳士的な戦い

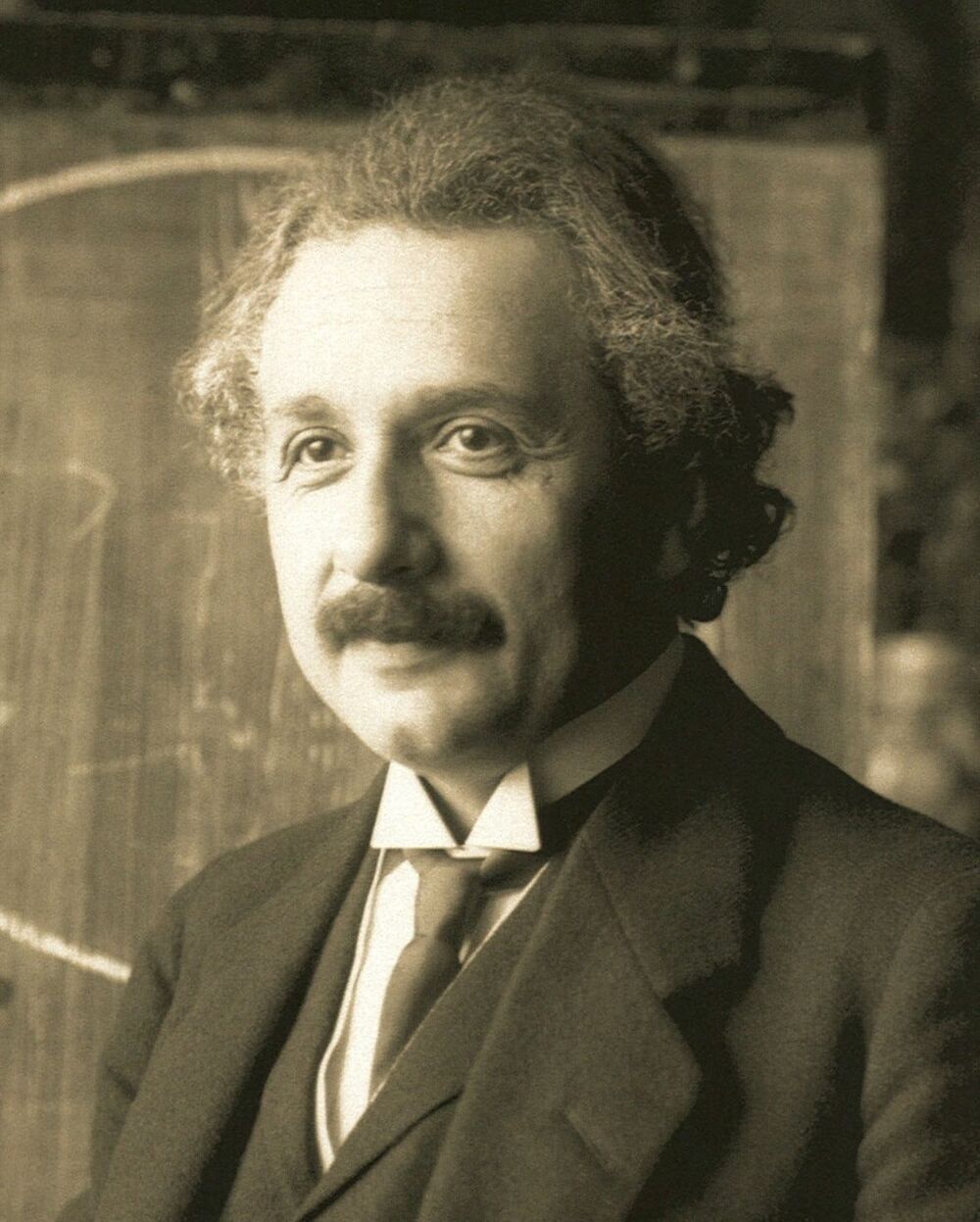

委員会のこだわりは、分野だけではなく受賞テーマにも注がれる。最も大きな“事件”はアインシュタインの受賞テーマ、すなわち受賞理由だ。

1905年、アインシュタインは三つのいずれも革命的な論文を発表した。前述したように、この年は「奇跡の年」といわれている。光電効果の理論(3月発表)、ブラウン運動の理論(5月発表)、特殊相対性理論(6月発表)の三つをこの年に発表した。

アインシュタインは1922年、来日する8日前に船上でノーベル物理学賞受賞の一報を受けたが、受賞理由は「理論物理学への貢献、特に光電効果の理論に対して」であった。アインシュタイン自身は特殊相対性理論とその後に発表した一般相対性理論が受賞対象になると思っていたようだ。1921年度は第一次大戦終結直後の様々な混乱がありノーベル賞は保留になっていた。それでアインシュタインの受賞は1921年度受賞ということになり、1922年度は「原子構造と原子からの放射の研究」に対してニールス・ボーアが受賞した。

ノーベル財団によって刊行されたNOBEL LECTURES Including Presentation Speeches And Laureates’ Biographies PHYSICS 1910-1921 (Published for the Nobel Foundation in 1998 by World Scientific Publishing Co. Pte. Ltd.) を読むと、委員会とアインシュタインの間にひそかな戦いがあったことが窺い知れる。

アインシュタインの受賞講演とノーベル委員会の脚注

冒頭に委員長のアレーニウスによる受賞理由が述べられている。概略を記すと、「アルベルト・アインシュタインは少なくとも3つの大きな貢献を物理学並びに人類に対してなした。相対性理論は素晴らしい理論だが、いまだ十分な実証がなく依然哲学的なレベルにとどまっている。実際、アンリ・ベルグソンらの哲学者の間で熱心に議論されている。ブラウン運動の理論も素晴らしい貢献であるが、古典物理学の問題である。

これらに対して、光電効果の理論はマイケル・ファラデーが電気化学(electro-chemistry)の基礎を作ったのに対してアインシュタインの光電効果の理論は光化学(photo-chemistry)の基礎と定量化に道を開いたと言える。しかも、この理論はマックス・プランクの発見以降物理学を革新しつつある量子論の正しさを保証するという意味でも画期的な理論である。

1919年にアーサー・エディントンが率いるイギリスの観測隊が皆既日食において太陽周辺で光が曲がっていることを観測したにもかかわらず、相対性理論に対して委員会は物理学の理論としては認めなかったのである。これはアインシュタインの観点とは全く異なるものであり、アインシュタインはこの委員会の判断を認めがたかったのだろうと思われる。

また、ファラデーとの比較を持ち出すことで委員会はアインシュタインの光電効果の理論がいかに他に抜きんでたものであるかを示そうとしたが、アレーニウスが物理学者というよりは化学者であったので(実際ノーベル化学賞を受賞した)、光電効果の理論を光化学の先駆をなしたと位置付けたこともアインシュタインをいらだたせたのではないかと推測する。

https://commons.wikimedia.org/wiki/File:Einstein1921_by_F_Schmutzer_2.jpg

冒頭のアレーニウスの受賞理由の脚注に「スウェーデンから遠く離れたところにいたので、アインシュタイン教授は授賞式には参加できなかった」とある。アインシュタインは1923年7月にイエテボリにあるNordic Assembly of Naturalistsで受賞講演を行った。上記講演集では受賞理由に引き続いてアインシュタインの講演記録がある。なんと、受賞講演として「相対性理論」に終始する講演を行った。委員会は脚注をつけた。「この講演はノーベル賞受賞当時には行われなかったので、光電効果の発見に関したものではなかった」。

なぜAI研究に物理学賞? 生成系AIを生んだ研究

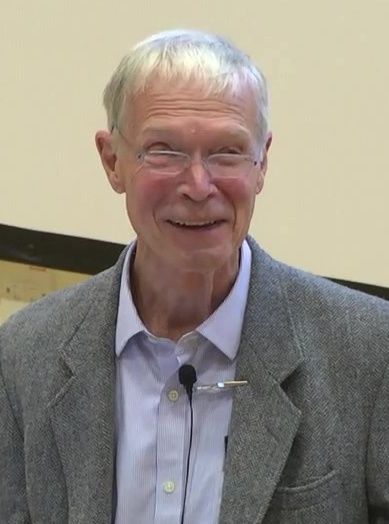

さて、今回対象になったのは、ジョン・ホップフィールドとジェフリー・ヒントンの二名の業績である。ホップフィールドは2021年度の対象の一つになったスピングラス理論からヒントを得て、脳の神経回路を模したANN(人工神経回路)を作った。いわゆるホップフィールド・ネット(HN)である(図1)。

https://commons.wikimedia.org/wiki/File:John_Hopfield_2016.jpg

脳のニューロン(神経細胞)をネットワークを構成する個々のノードと見立て、ノード間を全結合し(回帰型ニューラルネット、略してRNN)、結合の強さはランダムに選ぶことができ、スピングラスの統計物理理論が使える。これをもとにして、パタンの記憶をエネルギー関数の小さい値(極値)に対応させることで記憶状態をアトラクター(周りを引き寄せる吸引体)として表現した。そしてこのANNにどの程度の記憶が埋め込めるかを試算した。HNは連想記憶のモデルである。

ホップフィールドの提案以前に日本を含めて世界中で連想記憶のANNモデルは提案されていた。にもかかわらずなぜ委員会はそれらに注目しなかったのか。HNのインパクトは、連想記憶モデルはスピングラスに類似の振る舞いを示すANNによって作られるということを示したことだった。それゆえスピングラスの研究で発展した高度な統計物理理論が使えて、記憶容量などを理論的に導くことができることになる。そして、ホップフィールドはそれを実行した。

丸はノード(ニューロンのモデル)、矢印付き線分はノード間の結合を表す。結合の強さを記憶パタン(ノードの状態パタン)に対する各ノードの相関で決める(ヘブルールという)と記憶パタンはアトラクターとして表現できるので、記憶パタンの一部が欠けたような、あるいは全体がぼやけたようなパタンを入力するとニューラルネットのダイナミクスは記憶状態に収束して安定化する(連想記憶)。

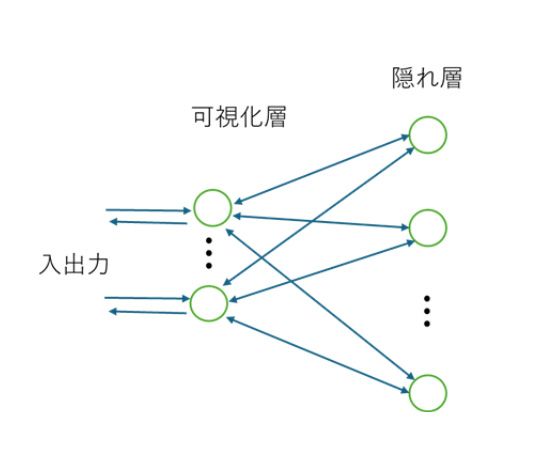

対して、ジェフリー・ヒントンはノードの状態確率を統計物理のボルツマン分布に従って出力するボルツマン・マシーン(BM)を、深層学習研究のパイオニアの一人であるテレンス・セイノフスキーらと共同で考案した。彼らは可視化層と隠れ層を用意して、可視化層のみが入出力を担うとした(隠れ層は直接入出力情報を受け取らないのでその名がある。中間層とも呼ばれる)。また、全てのノードが結合すると仮定した。これは計算上効率的でなく、のちに彼らは制限ボルツマン・マシーン(RBM)を提案した(図2)。

https://commons.wikimedia.org/wiki/File:Geoffrey_Hinton_at_Collision_2024_in_Toronto_(cropped).jpg

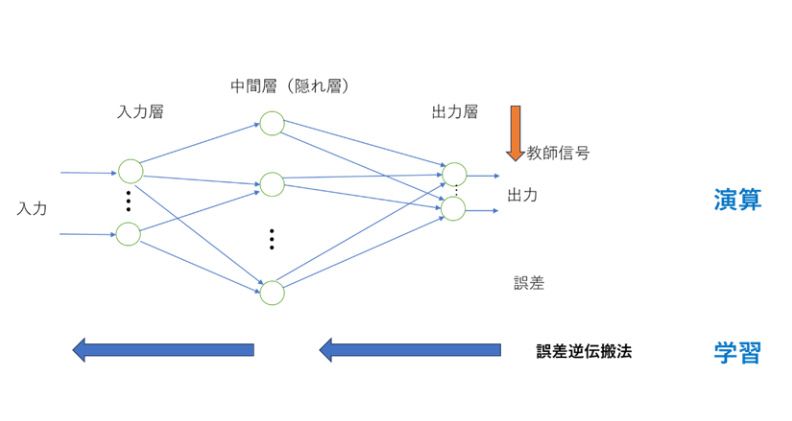

RBMでは可視化層、隠れ層それぞれの層内でのノード間の結合をなくし、可視化層と隠れ層の間にだけ全結合があるとした。これで性能はずいぶんと良くなったが、これはいわゆるフィードフォワード型のニューラルネット(いわゆる1950年代にフランク・ローゼンブラットによって提案されたパーセプトロン )そのものである。隠れ層の数を増やしていけば、現在の生成系AIの原型である深層神経回路になる。

この先駆は福島のネオコグニトロンである。深層神経回路の学習はバックプロパゲーション(BP、誤差逆伝搬法)と呼ばれているもので、出力層のノードの状態と望ましい状態との誤差を計算し、誤差を出力層から入力層に向かって逆向きに伝搬させていく方法である(図3)。このとき、誤差を結合の重みなどで微分して勾配を求め、勾配によって重みなどを変化させていく。この方法はBPの提唱より20年ほど前にB.ウィドローら(2層の場合)や甘利(3層以上)によって提案されていた“勾配法”と本質的には同じアルゴリズムであるので特段目新しいことではない。深層学習の基本というならば甘利の方法が先駆的である。

入出力は可視化層のみで行われ、結合は可視化層、隠れ層間のみにあり、ボルツマンマシーンにはあった層内の結合はなくしている。

RBMの可視化層を入力層と出力層に分離して、前向き結合(フィードフォワード)のネットワークとして表現しなおした。中間層である隠れ層の数を増やしたものが深層神経回路で、福島のネオコグニトロンが先駆である。深層学習は出力ユニットの誤差を逆向きに伝搬させ、誤差と関係したすべてのユニット間の結合を修正することで行われる。甘利の勾配法が先駆である。

深層神経回路をさらに強力にしたのは、長短期記憶(LSTM)回路とアテンション機構(Transformer)の追加であろう。LSTMは回帰型ニューラルネット(RNN)により実装されるが、回帰回路の時間ステップを多層のフィードフォワード回路に置き換えて、さまざまな長期、短期の記憶が可能になる深層神経回路が作られた。また、ホップフィールドの連想記憶におけるアトラクターダイナミクスは画像や文章のある部分にだけ着目するアテンション機構として再利用された。これにより、格段に処理スピードと計算可能な関数の容量が上がったと考えられる。

また、ホップフィールドらはHNのように結合重みの変更による学習ではなく、記憶パタンとネットワークの状態の内積(記憶に近いかどうかの指標)によって記憶の重み付けをして出力とすることで、記憶容量をノード数の指数関数で増やせることを理論的に示した。この「現代版HN」は生成系AIが膨大な数のパタンを学習できることを可能にしたのだ。